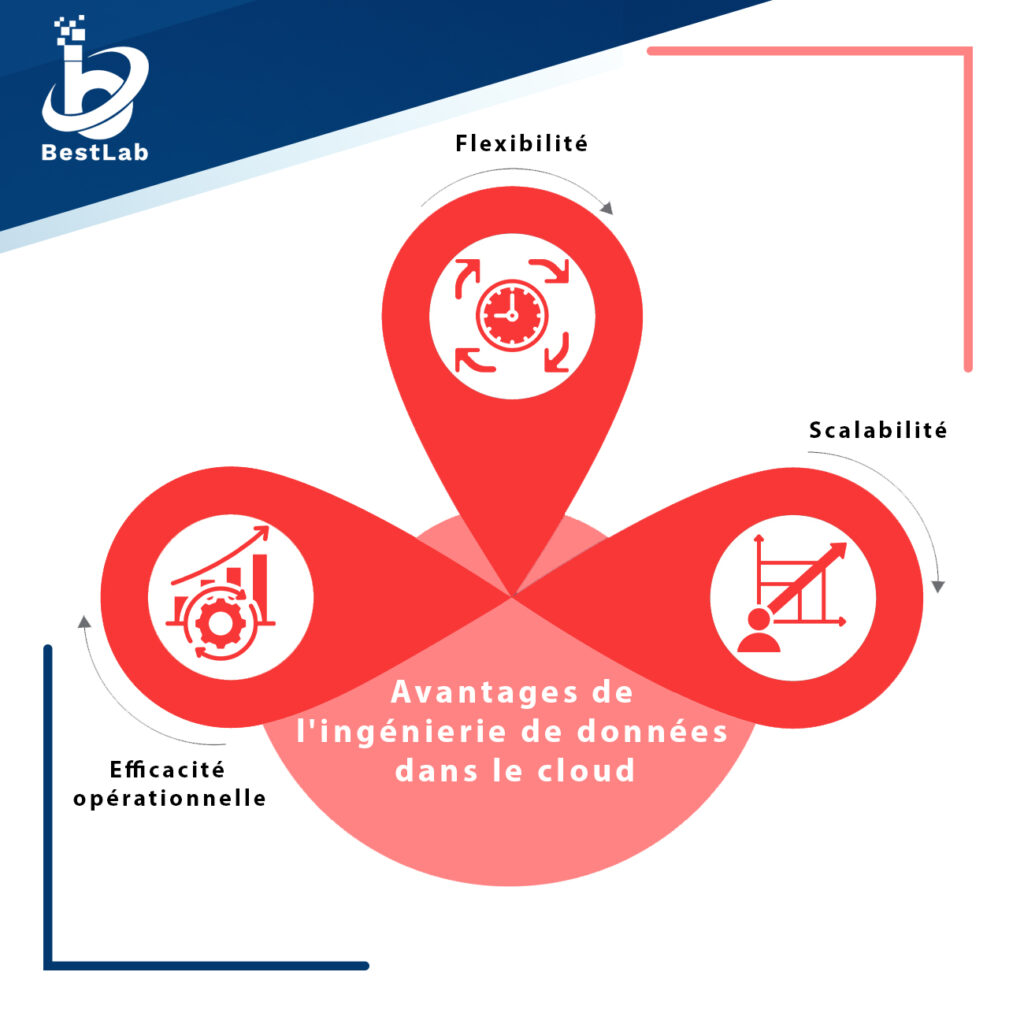

L’ingénierie de données dans le cloud représente un pilier fondamental de la transformation numérique des entreprises modernes. En effet, dans un paysage où les données sont devenues le carburant de la croissance et de l’innovation, les organisations doivent exploiter efficacement leurs ressources pour rester compétitives. L’ingénierie de données dans le cloud offre une solution agile et évolutive à ce défi croissant, en exploitant les capacités des infrastructures cloud pour traiter, stocker et analyser des volumes massifs de données.

Comparaison des fonctionnalités

Critères de comparaison | Apache Spark | AWS Glue | Google BigQuery |

Vitesse de traitement | Traitement rapide des données distribuées à grande échelle grâce à son moteur de traitement en mémoire. | Performances solides pour les tâches de préparation et d’intégration de données, mais moins optimisé pour le traitement massif de données en temps réel. | Excellent pour les requêtes SQL sur de grands ensembles de données avec des temps de réponse très rapides, mais moins adapté au traitement en temps réel. |

Gestion des données en temps réel | Prise en charge de flux de données en temps réel grâce à Spark Streaming et Structured Streaming. | Fonctionnalités de streaming limitées par rapport à Spark, mais permet la gestion des données en temps réel via Kinesis Streams et Firehose. | Intégration native avec Dataflow pour le traitement de données en temps réel, offrant une latence très faible et une haute disponibilité. |

Facilité de déploiement | Nécessite une configuration et une gestion plus complexes, mais offre une grande flexibilité pour le déploiement sur diverses infrastructures cloud. | Entièrement géré par AWS, ce qui simplifie considérablement le déploiement et la gestion des tâches ETL. | Entièrement géré par Google Cloud, avec une configuration et un déploiement simples via la console GCP. |

Compatibilité avec les sources de données | Prend en charge une variété de sources de données, y compris les fichiers, les bases de données, les systèmes de fichiers distribués, etc. | Intégration native avec les services AWS tels que S3, Redshift, RDS, DynamoDB, etc., mais peut nécessiter des efforts supplémentaires pour l’intégration avec des sources externes. | Intégration facile avec les services Google Cloud et les sources de données externes via le service de transfert de données de Google Cloud. |

Flexibilité | Offre une grande flexibilité grâce à son support pour plusieurs langages de programmation (Scala, Python, Java, R). | Moins flexible en termes de langages de programmation, principalement basé sur Python pour la création de jobs ETL. | Offre une flexibilité intermédiaire, prenant en charge les requêtes SQL standard, mais limité aux fonctionnalités offertes par le langage SQL. |

BestLab est une société de conseil en informatique spécialisée dans l'Intelligence Artificielle et le Big Data.

Besoin d’expertise en IA et big data ? On vous rappelle pour en discuter !